Robustesse et incertitude dans les modèles de réseaux de neurones

Ces dix dernières années, les modèles de réseaux de neurones profonds (deep learning) ont permis de nombreuses avancées dans le domaine de la reconnaissance visuelle, avec des applications transformantes par exemple dans celui de la médecine, du contrôle qualité ou de la voiture autonome. Ces modèles neuronaux sont entraînés sur de gros volumes de données afin de prédire des caractéristiques précises. Dans le cadre de la voiture autonome par exemple, ils peuvent servir à détecter les différents objets présents dans la scène (signalisation, véhicules, piétons, etc.) afin de mieux guider les décisions prises par le véhicule.

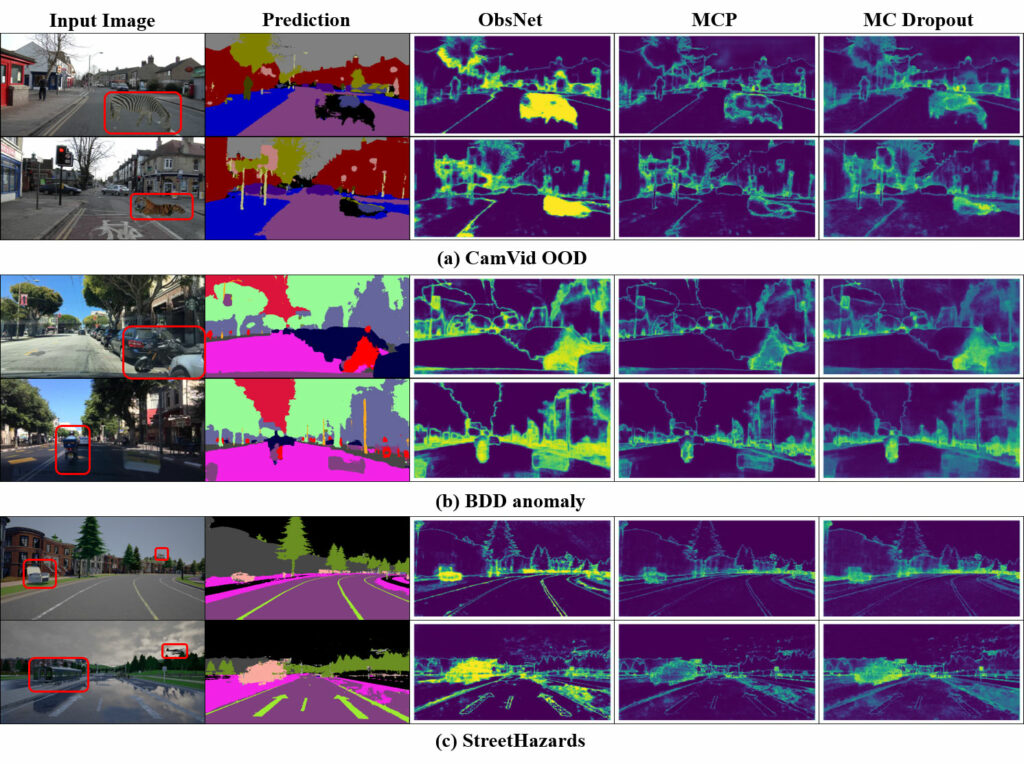

Or ces prédictions ne sont basées que sur des critères statistiques et commettent donc forcément des erreurs de temps à autre. Dans les cas critiques comme la médecine ou la voiture autonome, il devient crucial de détecter quand les prédictions sont erronées. Ces erreurs peuvent avoir deux origines : soit parce que le réseau de neurones a proposé une mauvaise prédiction – par exemple, confondre un piéton et un cycliste dans la voiture autonome –, soit parce qu’il n’y avait pas de bonne réponse – par exemple, une girafe sur la route alors que cette catégorie n’existe pas dans les prédictions du réseau de neurones.

Pour résoudre cette question de fiabilité des réseaux de neurones, nous nous intéressons à quantifier l’incertitude sur les prédictions qu’ils émettent, en particulier dans le second cas correspondant aux données invraisemblables menant à des prédictions fausses. Puisque ces données n’existent pas dans l’ensemble d’entraînement, elles produisent des « angles morts » dans le réseau de neurones. Celui-ci devient incapable de prendre en compte leurs caractéristiques visuelles. Nous proposons, pour traiter ce problème, de générer des motifs visuels dont l’objectif est de contraindre le réseau à se mettre en erreur. Les mises en erreur ainsi générées permettent de détecter les angles morts et par là même de quantifier l’incertitude de la prédiction.